Mehr Sicherheit, mehr Privatsphäre – dafür setzte sich Apple in der Öffentlichkeit stets ein. Nun rüttelt der Tech-Riese an diesen Grundpfeilern. Apple hat am Donnerstag ein Schutz-Paket angekündigt, um gegen Kindesmissbrauch vorzugehen. Mit diesen Massnahmen will Apple das erreichen:

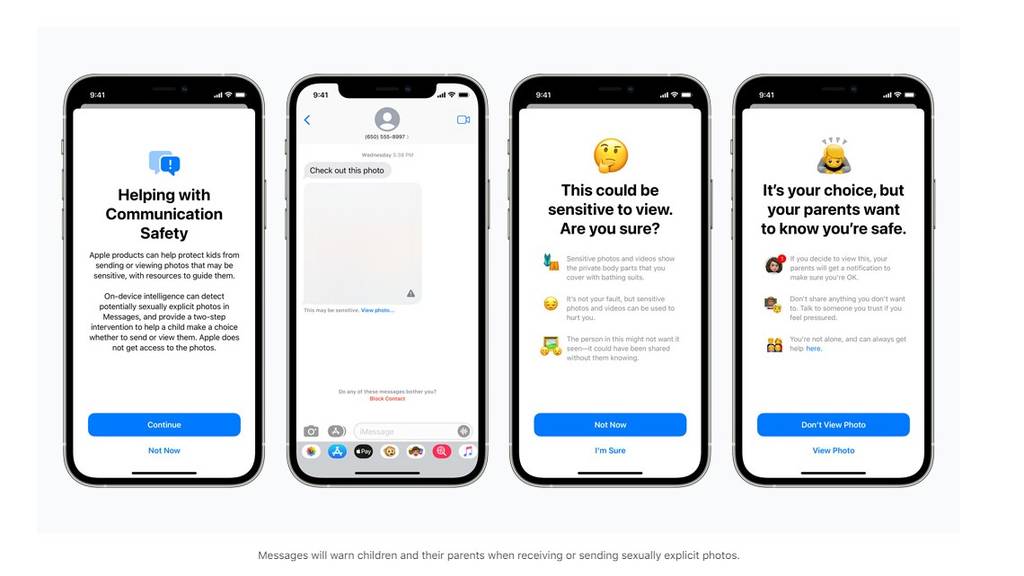

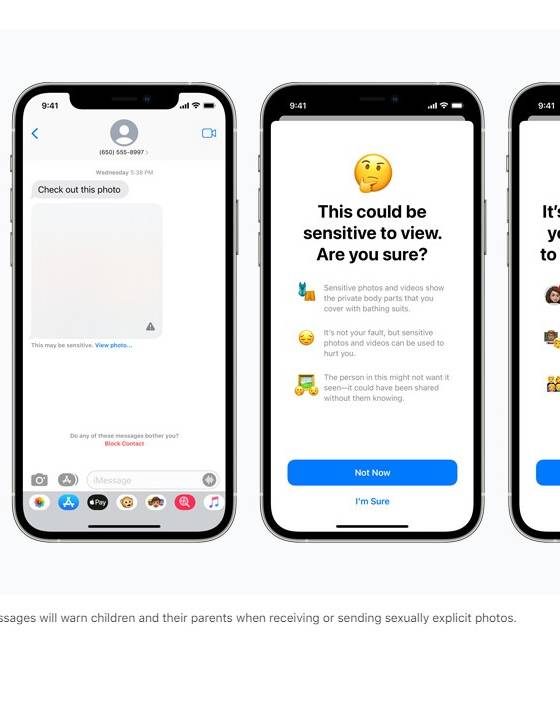

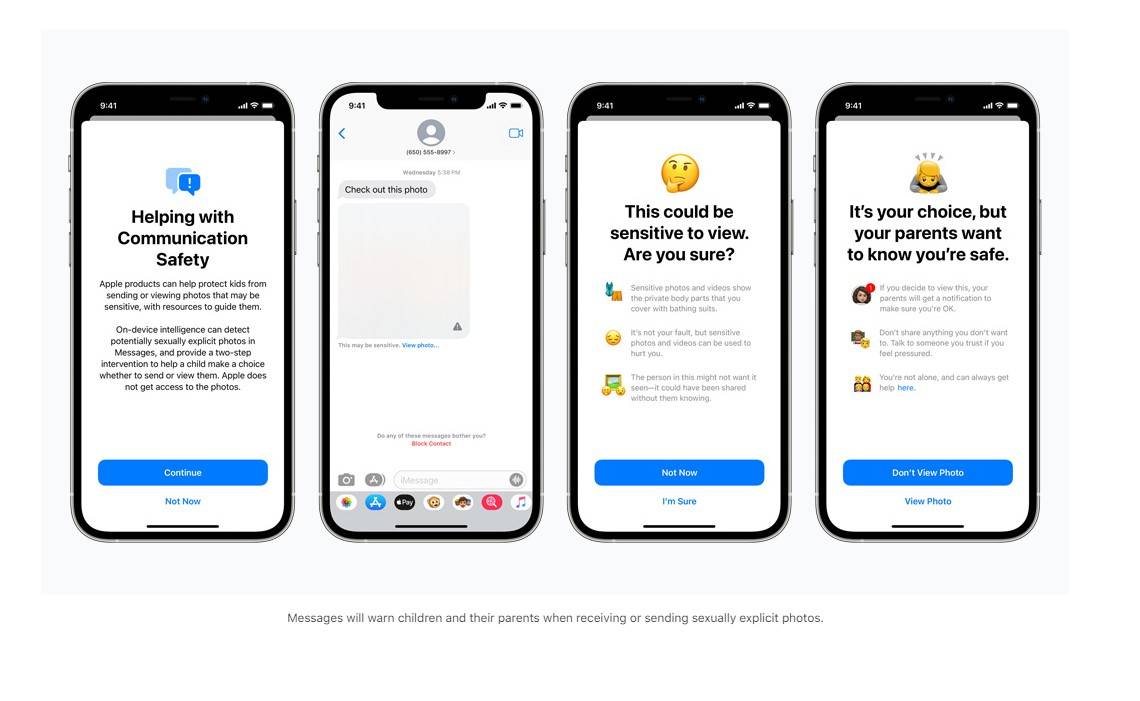

- iMessage warnt Kinder vor pornografischen Inhalten.

- Bevor Bilder in der iCloud landen, werden sie gescannt.

- Sprachassistent Siri hilft bei Notsituationen und weist auf Anlaufstellen hin.

- Ab iOS 15 will Apple eingreifen, sobald der User nach missbräuchlichen Inhalten sucht.

Apple betonte, dass dies im Einklang mit der Privatsphäre geschehe. Die Dienste starten vorerst in den USA, dürfte aber auch zu uns kommen.

Wenn harmlose Bilder den Account sperren

Kryptografie-Professor Matthew Green hält Apples Schutzdienste für keine gute Idee. Es könne zwar ein Segen sein, um Kinderpornografie auf den Handys zu finden. Aber Green stellt die Frage, was wohl eine autoritäre Regierung mit so einem Tool bewirken könne.

«Letztendlich könnte es eine Schlüsselrolle bei der Überwachung von verschlüsselten Nachrichtensystemen spielen», so Green auf Twitter.

Imagine someone sends you a perfectly harmless political media file that you share with a friend. But that file shares a hash with some known child porn file? pic.twitter.com/YdNVB0xfCA

— Matthew Green (@matthew_d_green) August 5, 2021

Ein harmloses Bild könnte eine Account-Sperre mit sich bringen. Ein Bild vom Kind in der Badewanne könnte vom System falsch gedeutet werden.

Snowden warnt vor Massenüberwachung

Auch bei Whistleblower Edward Snowden läuten die Alarmglocken. «Apple rollt damit die Massenüberwachung auf die ganze Welt aus.» Wenn sie heute nach Kinderpornos scannen, könnten sie morgen nach allem scannen, tweetet Snowden.

🚨🚨 Apple says to "protect children," they're updating every iPhone to continuously compare your photos and cloud storage against a secret blacklist. If it finds a hit, they call the cops.

— Edward Snowden (@Snowden) August 6, 2021

iOS will also tell your parents if you view a nude in iMessage.https://t.co/VZCTsrVnnc

«Es ist unmöglich, ein Scansystem auf Geräteseite zu entwickeln, das nur für sexuell eindeutige Bilder verwendet werden kann, die von Kindern gesendet oder empfangen werden», schreibt die EFF (Electronic Frontier Foundation) zu Apples Plänen. Die Konsequenz: Selbst ein gut gemeinter Versuch, ein solches System zu entwickeln, werde Türen für weitergehenden Missbrauch öffnen sowie wichtige Versprechen der Messenger-Verschlüsselungen brechen.

Der Chefredaktor von «heise security» und Sicherheitsexperte, Jürgen Schmidt, warnt gar vor einer «Totalüberwachung durch die Hintertür». Es gehe beim Scanning um nichts weniger als «im System verankerte Wanzen, die permanent auf unseren Geräten nach inkriminierten Inhalten suchen», sagt Schmidt. Erst suche das System nur Kinderpornografie, später nach Terroristen, Menschenhändlern, Drogen-Dealern. Man werde ständig überwacht. Weil sich Apple an geltendes Recht halten müsse, würden Staaten Zugriff auf die Suchkriterien und die damit ausgelösten Alarme bekommen.

Andere Hersteller würden nachziehen, bis dann irgendwann «diese Form der Überwachung sogar vorgeschrieben wird».